How do I find out my motherboard model?

Posted by Julia Werner •

1,8 Exaflops? Wie schnell Teslas Superrechner wirklich ist und was „Dojo“ später können soll

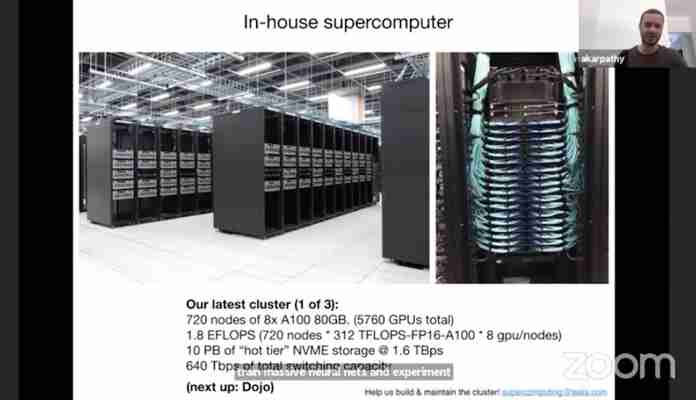

Vergangene Woche gab Andrej Karpathy, Chef für Künstliche Intelligenz (KI) bei Tesla, bei einer Konferenz einige interessante Einblicke in die Arbeit seines Teams an der neuen Generation der Autopilot-Software FSD (kurz für Full Self-Driving). Aber er verwirrte auch, denn zum einen bezeichnete er einen der Computer, mit denen Tesla seine Beta-Software trainiert, als den wohl fünftschnellsten der Welt. Auf der anderen Seite nannte Karpathy eine Rechenleistung von 1,8 Exaflops – was die Maschine locker zum stärksten Supercomputer überhaupt machen würde. Und was stimmt jetzt?

Eine Frage der Genauigkeit

Ein Blick in das Datenblatt des verwendeten Nvidia-Grafikprozessors schafft Klarheit. Tesla verwendet Grafikprozessoren des Typs A100. Jeder davon kommt schon allein auf 312

Billionen Fließkomma-Operationen pro Sekunde, abgekürzt als Teraflops (oder sauberer als Teraflops/s). Und weil Tesla 5760 von diesen Prozessoren nutzt, kommt man auf den Wert von 1,8 Exaflops, den Karpathy nannte.

Doch das ist fast buchstäblich nur die halbe Wahrheit – denn der A100 schafft seine 312 Teraflops nur mit halber Genauigkeit. Die Genauigkeit bezeichnet die Anzahl der Bytes, mit der eine Zahl verarbeitet wird. Je mehr Bytes und damit Stellen die Zahl hat, desto genauer ist die Berechnung und desto langsamer wird relativ gesehen der Prozessor. Supercomputer werden normalerweise mit doppelt so hoher Genauigkeit wie der bei dem Nvidia-Chip verglichen, und dann sieht es für den A100 ganz anders aus: Statt 312 Teraflops schafft er nur noch 19,5 Teraflops. Bei 5760 Stück davon ergeben sich so gut 112 Petaflops, also etwa 0,1 Exaflops.

Damit passt dann auch alles wieder zusammen. Der offiziell leistungsfähigste Supercomputer der Welt heißt Fugaku, steht in Japan und kommt auf 442 Petaflops. Das klingt weniger als die von Teslas KI-Chef Karpathy genannten 1,8 Exaflops, ist es aber wie oben erklärt nicht. Den fünftschnellsten Rechner der Welt wiederum könnte Tesla mit dem vergleichbaren Wert von 112 Petaflops aktuell durchaus schon haben.

Dojo-Infos bei Teslas KI-Tag?

Ebenfalls in dieses Bild passt, dass der nächste Supercomputer, den Tesla-Chef Elon Musk schon Dojo getauft hat, etwa zehnmal so schnell sein soll wie der jetzige – und dann tatsächlich die Exaflops-Grenze überschreiten. Das dürfte das KI-Training der FSD-Software erheblich beschleunigen. In einem Monat „oder so“, wie Elon Musk in dieser Woche twitterte, will Tesla einen KI-Tag veranstalten, um neues Personal zu rekrutieren. Bei dieser Gelegenheit dürfte er auch mehr über den Dojo-Rechner verraten.

Supercomputer: Chinas Exascale-Rechner OceanLight setzt auf 14-nm-Technologie

Für Spitzenleistung braucht es nicht immer die neueste Technologie. Ein Beweis dafür ist der OceanLight-Rechner von Sunway, der im National Supercomputing Center Chinas steht und nach letztjährigen Berichten die Grenze von 1 ExaFLOPS geknackt hat. Im Linpack-Benchmark erzielte der Rechner einen Rmax-Wert von 1,05 ExaFLOPS, während die Rpeak-Performance bei 1,3 ExaFLOPS liegen soll.

Gleichwohl das erheblich schneller ist als der aktuell weiterhin amtierende Spitzenreiter der Top500-Liste Fugaku aus Japan (442 PFLOPS Rmax), darf sich der Supercomputer mangels Benchmarks nicht in der Liste verewigen, wobei China mit dem Tianjin Tianhe-3 über ein noch weitaus schnelleres System mit geschätzt 1,3 ExaFLOPS (Max) und 1,7 ExaFLOPS theoretischer Spitzenleistung (Peak) verfügen soll.

Mit kleinen oder auch größeren Details der Architektur des OceanLight-Supercomputers hat sich in hiesigen Gefilden die Webseite beschäftigt. Als Basis diente dabei ein Paper, welches von der Alibaba Group, Tsinghua University, DAMO Academy, Zhejiang Lab und Beijing Academy of Artificial Intelligence veröffentlicht wurde. Kern der wissenschaftlichen Arbeit ist eigentlich ein Machine-Learning-Modell mit dem Namen BaGuaLu, wobei in Teilen auf die genutzte Rechnerarchitektur des OceanLight eingegangen wurde. BaGuaLu arbeitet auf mehr als 37 Millionen Kernen mit 14,5 Billionen Parametern (offenbar FP32 Single-Precision) und kann wohl bis zu 174 Billionen Parameter skalieren, was einer Annäherung an den sogenannten "Brain-Scale" entspricht. Gemeint ist damit eine ähnlich hohe Anzahl an Parametern wie es Synapsen im menschlichen Gehirn gibt.

SW26010-Pro Compute Engine im Detail

Schon im vergangenen Jahr hat man sich bei damit beschäftigt, wie ein Exascale-System durch das National Research Center of Parallel Computer Engineering and Technology (NRCPC) gebaut sein könnte. Man kam dabei zu dem Schluss, dass dafür genutzte 14-nm-Chips womöglich auf ähnliche Taktraten wie die 260-Kern-Prozessoren SW26010, verwendet im Sunway TaihuLight und gefertigt in 28nm, gedeckelt sind, um die Temperaturen im Zaum zu halten. Gleichzeitig spekulierte man auf eine Verdoppelung der Compute-Elemente und ebenso der Vector-Breiten auf 512-Bit sowie Kabinette, die die jeweiligen Nodes beheimaten.

Zumindest in letzteren Punkten stimmten die Thesen von Einzig bei den Taktraten der genutzten SW26010-Pro-Prozessoren lag man daneben. Anhand eines Diagramms lässt sich derweil ein detaillierterer Blick auf die Compute-Engine des Prozessors werfen.

SW26010-Pro Compute Engine Quelle: via

Die darin enthaltenen Rechenkerne sind in insgesamt sechs Gruppen mit achtmal acht Kernen (Compute Processing Element, CPE) unterteilt und verfügen über ein großes Management-Processing-Element (MPE) nebst DDR4-Speicherinterface (16 GiByte, 51,4 GB/sec). In jedem CPE finden sich derweil 256 KiByte an L2-Cache und insgesamt vier Logik-Blöcken, die Unterstützung für FP64- und FP32-Berechnungen einerseits und FP16 sowie BF16 andererseits bieten. Verbunden sind die sechs CPEs derweil über ein Ring-Interconnect mit zwei Netzwerk-Interfaces.

Was die Performance eines einzelnen SW26010-Pro angeht, stehen hier 14,03 PetaFLOPS bei FP64- oder FP32-Kalkulationen bereit, während 55,3 PetaFLOPS für FP16- beziehungsweise BF16-Berechnungen erzielt werden. Was die Konfiguration des OceanLight-Systems angeht, spricht man von einer bekannten getesteten Größe von 107.520 Nodes mit jeweils einem SW26010-Pro pro Node und damit in Summe 41,93 Millionen Rechnenkernen verteilt auf 105 Rechner-Kabinette.

Vermuteter Takt von 2,22 GHz und Skalierbarkeit auf bis zu 160 Kabinette

Die Funktionsweise des Systems wird anhand eines weiteren Diagramms verdeutlicht. Die einzelnen Nodes werden in einer Supernode zusammengefasst, die wiederum in einer 3x oversubcribed und non-blocking Fat-Tree-Topologie verbunden sind. Der Interconnect seit laut dem Paper proprietär, gleichwohl man bei annimmt, dass es sich womöglich um eine angepasste Version des InfiniBands handelt, wie es im originalen TaihuLight-System zum Einsatz kam. Hinsichtlich der Taktraten der einzelnen SW26010-Pro-Chips lassen sich zwar keine harten Fakten finden, auf Basis der geschilderten Eckdaten mitsamt Performance-Angaben lässt sich jedoch eine Geschwindigkeit von 2,22 GHz ausrechnen, mit denen die Prozessoren arbeiten dürften.

Sunway OceanLight Architektur Quelle: BaGuaLu

Nimmt man nun die bisher getestete Ausstattung von 107,250 Nodes zur Grundlage, errechnet sich eine theoretische Peak-Performance von 1,51 ExaFLOPS. Angenommen wird allerdings, dass das OceanLight-System auch bis zu 160 Kabinetten ausgeweitet werden könne, was letztlich 163,840 Nodes und 2,3 ExaFLOPS Peak bei F64- und FP32-Berechnungen bedeuten wird, während bei 120 Kabinetten 1,72 ExaFLOPS Peak im Raum stünden.

Das im Paper zentral thematisierte BaGuaLu-Modell werkelte derweil auf einem OceanLight-Supercomputer mit 96.000 Nodes und 37,44 Millionen Kernen in Summe bei 14,5 Billionen Parametern. Würde man besagte Parameter auf BF16 oder FP16 umstellen, wären mit dem System bereits 29 Billionen Parameter kalkulierbar, während ein Setup mit 160 Kabinetten hier mit 49,5 Billionen Parametern aufwarten würde. Wie die 174 Billionen Parameter, die im Paper erwähnt werden, zu erreichen sind, ist man sich im Bericht von nicht so sicher. Eine solche Zahl wäre zumindest theoretisch erzielbar, würde man Unterstützung für INT8- und INT4-Datenformate hinzufügen. Mit INT4 wären gemäß der eigenen Rechnung 198 Billionen Parameter erzielbar.

How do I find out my motherboard model?

Non-root user variant

I would like to suggest a variant for the unprivileged users, since it's not always possible to execute commands as root (some users simply cannot and however it is always a good practice to avoid running commands as root when it's not needed) and or there is no intention or possibility to install new programs:

cat /sys/devices/virtual/dmi/id/board_{vendor,name,version}

that it is a short version, shell expanded, of cat /sys/devices/virtual/dmi/id/board_vendor /sys/devices/virtual/dmi/id/board_name /sys/devices/virtual/dmi/id/board_version and gives as a spartan output respectively vendor, name and version:

FUJITSU D3062-A1 S26361-D3062-A1

Note:

Inside the path /sys/devices/virtual/dmi/id/ it's possible to find some files with information about BIOS, board (motherboard), chassis... not all are readable by an unprivileged user due to a security or privacy concerns.

Privileged user variant

Of course, e.g, a sudo cat board_serial (that usually is readable only by root, -r-------- ) or a sudo cat board_* can easily overcame this limit...

...but, maybe, if privileges are available it's more convenient to use dmidecode as suggested in other answers as well.

Below is the version I prefer, due to the compactness of its output:

sudo dmidecode -t 1 # or sudo dmidecode | grep -A4 '^Base' # output more short and compact

The previous command with -A3 will show only the first 3 lines and it is the short version for

sudo dmidecode | grep -A4 '^Base Board Information' that should be better to use if in a script.

Example output:

Base Board Information Manufacturer: FUJITSU Product Name: D3062-A1 Version: S26361-D3062-A1 Serial Number: MySerialNumber(1)

(1) if it is protected for unprivileged users, then maybe it's better to avoid posting it :-)

Tagged:

Leave a Reply

neueste Artikel

- How to Check The Serial Number...

Buying a huawei watch can sometimes be a dream come true, especially if you have had b... - Synology DiskStation Manager

Der DiskStation Manager (DSM) ist das Betriebssystem für die Network Attached Storage-Systeme (NAS... - SAN vs. NAS: Unterschied ...

„Big Data“ lässt grüßen! Laut einer Studie des Festplatten-Giganten Seagate soll sich der weltweit... - Online Banking Software: 4...

Wer Bankgeschäfte über das Internet erledigen möchte, muss dafür nicht zwingend über die Internets... - Ninite – das wohl nützlic...

System-Tools gibt es wie Sand am Meer. Die meisten versprechen viel und halten wenig. Wirklich gut... - Digitalisierung anpacken:...

Die Corona-Pandemie hat ohne Zweifel einen starken Beitrag zur Digitalisierung kleinerer und mitte...

populäre Artikel

- How to Check The Serial Number...

Buying a huawei watch can sometimes be a dream come true, especially if you have had b... - Synology DiskStation Manager

Der DiskStation Manager (DSM) ist das Betriebssystem für die Network Attached Storage-Systeme (NAS... - Online Banking Software: 4...

Wer Bankgeschäfte über das Internet erledigen möchte, muss dafür nicht zwingend über die Internets... - Einrichten einer lokalen...

Dieser Artikel richtet sich an alle Hobby-Webentwickler, die ihre erstellten Web-Projekte auf dem... - Digitalisierung anpacken:...

Die Corona-Pandemie hat ohne Zweifel einen starken Beitrag zur Digitalisierung kleinerer und mitte...

Lieblingsartikel

- SAN vs. NAS: Unterschied ...

„Big Data“ lässt grüßen! Laut einer Studie des Festplatten-Giganten Seagate soll sich der weltweit... - Online Banking Software: 4...

Wer Bankgeschäfte über das Internet erledigen möchte, muss dafür nicht zwingend über die Internets... - Ninite – das wohl nützlic...

System-Tools gibt es wie Sand am Meer. Die meisten versprechen viel und halten wenig. Wirklich gut... - Einrichten einer lokalen...

Dieser Artikel richtet sich an alle Hobby-Webentwickler, die ihre erstellten Web-Projekte auf dem...