Neuer Supercomputer für 15 Millionen Euro geplant

Posted by Julia Werner •

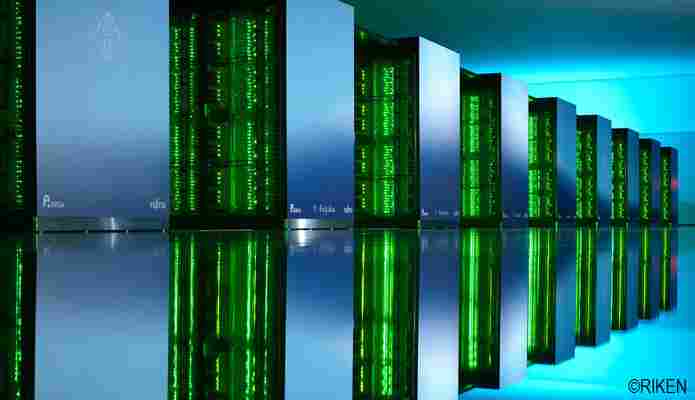

Mit dem Supercomputer Fugaku gegen die COVID-19 Pandemie

Am 15. November 2021 wurde Fugaku, gemeinsam vom japanischen Forschungszentrum RIKEN und Fujitsu entwickelt, zum vierten Mal hintereinander die Nummer 1 der TOP500-Liste der weltschnellsten Supercomputer. Noch wichtiger und beeindruckender ist die praxisnahe Nutzung dieses Supercomputers.

Bereits in der Designphase legten RIKEN und Fujitsu fest, dass Fugaku für viele reale Anwendungsfälle eine deutliche Beschleunigung erbringen soll. Außerdem lag der Fokus auf einer breiten Nutzbarkeit („Application First“).

Ausgezeichnete Leistung

Der Erfolg dieser Strategie zeigte sich kürzlich, als der renommierte ACM Gordon Bell Preis für die Spezial-Kategorie „High Performance Computing-Based COVID-19 Research“ an ein Team vom RIKEN Center for Computational Science und der Kobe University verliehen wurde. Satoshi Matsuoka und Makoto Tsubokura nahmen den Preis im Rahmen der internationalen Konferenz SC21 für die Arbeit „Digital Transformation of droplet/aerosol infection risk assessment realized on Fugaku for the fight against COVID-19“ entgegen.

Simulation von Tröpfchen und Aerosolen

Bereits im April 2020 – noch vor der kompletten Fertigstellung von Fugaku – stellten RIKEN und Fujitsu erste Partitionen dieses Supercomputers Wissenschaftler*innen zur Verfügung. Das Team von Prof. Makoto Tsubokura entwickelte eine Anwendung zur Simulation von Strömungen, die nun für die Bekämpfung der COVID-19 Pandemie eingesetzt wurde. Die Simulation berechnet, wie sich infektiöse Tröpfchen und Aerosole in der Luft verbreiten. Dafür werden Schutzmasken und Schutzschilde aus unterschiedlichen Materialien geprüft und deren Wirkung gegen die Verbreitung von Tröpfchen und Aerosolen mit Hilfe der Simulations-Berechnung bewertet. Hieraus wird ermittelt, wie groß das Risiko einer COVID-19 Infektion in unterschiedlichen Situationen ist. Fugaku konnte die Simulationen in der notwendigen hohen Auflösung skalieren und erreichte eine sehr schnelle Lösungszeit.

Im Rahmen unserer Born to transform Podcast-Reihe konnten wir in Episode 4 mit Prof. Tsubokura ausführlich über den Prozess sprechen. Er gab uns Einblicke in die Herausforderungen und die aus den Simulationen gewonnenen Erkenntnisse.

Mit Fugaku zur Entscheidung

Dank der hohen Rechenleistung von Fugaku konnten die Wissenschaftler*innen mit den Simulationen das Infektionsrisiko durch Aerosole für eine große Zahl an Szenarien auswerten. Innerhalb von etwa 1,5 Jahren wurden über 1000 Szenarien simuliert, wofür eine Rechenzeit von etwa 17,5 Millionen Fugaku-Rechenknoten-Stunden verbraucht wurde. So untersuchten die Wissenschaftler*innen beispielsweise das Ansteckungsrisiko in Räumen wie Büros, Klassenzimmern, Konzerthallen, Musikclubs und Restaurants. Analog wurden auch die Aerosol-Ausbreitung sowie die Risiken in öffentlichen Verkehrsmitteln wie Zügen, Taxis, Bussen und Flugzeugen analysiert und visualisiert. Auf Basis der Ergebnisse wurden konkrete Gegenmaßnahmen evaluiert und vorgeschlagen, die das Infektionsrisiko senken.

Während des gesamten Projekts arbeitete RIKEN eng mit Partnern aus der Industrie sowie mit den Regierungsbehörden zusammen. Die gewonnenen Erkenntnisse halfen bei der Entscheidungsfindung für geeignete Maßnahmen und Verpflichtungen wie das Tragen von Gesichtsmasken und Kontaktreduzierungen. Außerdem waren sie die Grundlage bei Entscheidungen, wann und ob öffentliche Einrichtungen und Geschäfte geschlossen beziehungsweise wieder geöffnet werden sollten.

Ausblick auf weitere Arbeiten

Bisher werten die Simulationen aus, wie sich die Tröpfchen und Aerosole von infizierten Personen über die Luft auf andere Menschen übertragen. Im nächsten Schritt geht es darum, zu verstehen, wie eingeatmete Tröpfchen und Aerosole innerhalb des menschlichen Körpers zu einer Infektion führen.

Hierfür wird derzeit ein kombiniertes Simulations-System einer Virus-Infektion entwickelt. Die aktuelle Simulation der Luftübertragung soll mit einer biologischen Simulation kombiniert werden, bei der die Atemwege des Menschen nachgebildet und die Reaktion der Immunzellen gegen die Virus-Invasion reproduziert wird.

Fazit

Die preisgekrönte Anwendung von RIKEN demonstriert eindrucksvoll, wie ein leistungsstarker Supercomputer wertvolle Erkenntnisse für die Bewältigung von gesellschaftlichen Herausforderungen liefert. Weitere Informationen zu Fugaku und den Supercomputern von Fujitsu finden Sie in diesem Blog-Beitrag sowie auf unserer Webseite.

Über eine weitere Anwendung, in der es um die Vorhersage von Tsunamis geht, planen wir noch einen separaten Artikel.

Mit 1820 Servern zum Supercomputer

Mit 1820 Servern zum Supercomputer

52 Petaflops – also 52 Billiarden Operationen pro Sekunde – beträgt die Leistung des unlängst in Betrieb genommenen Supercomputers HPC5. Laut dem italienischen Gas- und Erdölkonzern Eni handelt es sich dabei um den derzeit schnellsten Supercomputer in privatwirtschaftlicher Hand. Der Rechner steht in einem Green Data Center des Unternehmens südlich von Mailand und nutzt vor Ort erzeugte Solarenergie zur Reduzierung der Emissionen.

Der HPC5-Supercomputer bei Eni mit einer Spitzenleistung von 52 Petaflops.

Im HPC5 rechnen 1820 PowerEdge-C4140-Server von Dell EMC. Jeder dieser Server ist mit zwei Intel-Xeon-Scalable-Gold-6252-Prozessoren mit jeweils 24 Kernen und integrierter KI-Beschleunigung sowie vier GPU-Beschleunigern vom Typ Nvidia V100 Tensor Core ausgestattet. Verbunden sind die Server über ein InfiniBand-HDR-Netzwerk von Mellanox mit einer Geschwindigkeit von 200 GBit/s. Eni nutzt den Supercomputer mit seiner parallelen Architektur für die Verarbeitung von Big Data aus dem operativen Geschäft. Mit Hilfe komplexer Algorithmen werden etwa dreidimensionale seismische Bilder verarbeitet, Lagerstätten simuliert und Produktionsabläufe optimiert.

Neuer Supercomputer für 15 Millionen Euro geplant

Der Hochleistungsrechner des KIT wird durch ein noch leistungsstärkeres System ersetzt werden. (Foto: Markus Breig, KIT).

Der Supercomputer des Karlsruher Instituts für Technologie (KIT) ist nicht nur „superschnell“ und extrem sparsam, er wird auch sehr intensiv genutzt. Deshalb wird der aktuelle Hochleistungsrechner zwischen 2019 und 2021 stufenweise durch einen noch leistungsfähigeren Nachfolger ersetzt. Dafür stehen 15 Millionen Euro bereit. Das hat die Gemeinsame Wissenschaftskonferenz (GWK) am Freitag, 29. Juni, in Berlin beschlossen.

Der neue Supercomputer am KIT wird hälftig von Bund und Land finanziert. Die Förderung des Landes Baden-Württemberg folgt der Landesstrategie zu High Performance Computing und Data Intensive Computing, um ein international konkurrenzfähiges Niveau des Wissenschafts- und Wirtschaftsstandortes Baden-Württemberg sicherzustellen. Hierzu leistet der neue leistungsstarke Großrechner am KIT einen wesentlichen Beitrag. Er ist zentraler Bestandteil einer aufeinander abgestimmten Hoch- und Höchstleistungs-Recheninfrastruktur in Baden-Württemberg, die sich in drei Leistungsebenen mit ansteigender Rechenleistung gliedert. Durch die kooperativen Aktivitäten zwischen den wissenschaftlichen Rechenzentren des Landes Baden-Württemberg können die Herausforderungen bewältigt sowie institutionen- und disziplinübergreifende Mehrwerte erzielt werden.

Wissenschaftsministerin Theresia Bauer hat eine exzellente Forschungsinfrastruktur für eine exzellente Wissenschaft und eine innovationskräftige Wirtschaft als wichtiges Ziel formuliert. „Wir investieren in Supercomputing auf internationalem Top-Niveau. Mit dieser digitalen Infrastruktur ermöglichen wir vielversprechende Innovationen im Land“, so Bauer.

Ob Wissenschaftlerinnen und Wissenschaftler Verbrennungsprozesse in Flugzeugtriebwerken simulieren, den Klimawandel erforschen oder den Aufbau von Designermolekülen planen: Spitzenforschung produziert eine Unmenge von Daten, nutzt immer komplexere Simulationsmodelle und braucht deshalb höchste Rechenleistung sowie schnelle Datenspeicher. Mehrere Billiarden Rechenoperationen pro Sekunde und ein Speichersystem, das im Sekundentakt den Inhalt von 20 DVDs aufnehmen kann, soll der neue Supercomputer bieten.

„Derzeit nutzen fast 200 Forschungsprojekte aus ganz Deutschland unser System“, sagt Bernhard Neumair, Geschäftsführender Direktor des Steinbuch Centre for Computing (SCC) am KIT, das den aktuellen Forschungshochleistungsrechner (ForHLR) betreibt. Der 2016 in Betrieb gegangene und preisgekrönt energieeffiziente ForHLR II verfügt über 1.173 Knoten (1152 Rechenknoten mit je 64 Gigabyte und 21 Renderingknoten mit je 1 Terabyte), mehr als 24.000 Rechenkerne und 93 Terabyte Hauptspeicher. Er kostete 8,5 Millionen Euro. Die Mehrzahl der zu erledigenden Jobs benutzt schon heute 1.000 oder mehr Rechenkerne gleichzeitig, fast jeder zehnte nimmt gleich ein Viertel des gesamten Systems in Anspruch. Darüber hinaus können auf einem über 15 Quadratmeter großen Bildschirm mit 13 Megapixel 3-D-Simulationen supergenau dargestellt werden.

Aufgrund von Nutzerbefragungen rechnet Neumair in den nächsten Jahren mit einer Verdopplung bis Verdreifachung des Bedarfs an Rechenleistung allein aus den Ingenieur- und Naturwissenschaften. Dazu gehören etwa Vorhersagen des globalen Klimawandels und dessen Auswirkungen auf Landwirtschaft und Artenvielfalt oder das virtuelle Design von Werkstoffen nach Maß. Eine noch größere Steigerung wird seitens der Lebenswissenschaften erwartet, deren strategische Bedeutung durch die Entwicklung neuer Produkte oder Problemlösungen und der damit einhergehenden Biologisierung von Technik und Industrie zunimmt. Wegen des steigenden Nutzungsbedarfs, den aufwendigen Prozesse, wie die Simulation von Wolken in der Klimaforschung oder die Darstellung von Struktur und Funktion von Biomolekülen, die im Labor nicht direkt beobachtet werden können, mit sich bringen, werden in Zukunft deutlich mehr Rechenkerne notwendig sein. Um diese Vielzahl von Rechenkernen in einem System zu integrieren, werden Beschleuniger eingesetzt werden, etwa auf Basis von Grafik-Prozessoren.

Der Wissenschaftsrat, der die GWK berät, hat dieses wissenschaftliche und technologische Konzept sehr gut bis herausragend bewertet und somit zur Förderung empfohlen. Das neue System soll 2021 vollständig betriebsbereit sein.

Als „Die Forschungsuniversität in der Helmholtz-Gemeinschaft“ schafft und vermittelt das KIT Wissen für Gesellschaft und Umwelt. Ziel ist es, zu den globalen Herausforderungen maßgebliche Beiträge in den Feldern Energie, Mobilität und Information zu leisten. Dazu arbeiten rund 9 800 Mitarbeiterinnen und Mitarbeiter auf einer breiten disziplinären Basis in Natur-, Ingenieur-, Wirtschafts- sowie Geistes- und Sozialwissenschaften zusammen. Seine 22 300 Studierenden bereitet das KIT durch ein forschungsorientiertes universitäres Studium auf verantwortungsvolle Aufgaben in Gesellschaft, Wirtschaft und Wissenschaft vor. Die Innovationstätigkeit am KIT schlägt die Brücke zwischen Erkenntnis und Anwendung zum gesellschaftlichen Nutzen, wirtschaftlichen Wohlstand und Erhalt unserer natürlichen Lebensgrundlagen. Das KIT ist eine der deutschen Exzellenzuniversitäten.

Tagged:

Leave a Reply

neueste Artikel

- How to Check The Serial Number...

Buying a huawei watch can sometimes be a dream come true, especially if you have had b... - Synology DiskStation Manager

Der DiskStation Manager (DSM) ist das Betriebssystem für die Network Attached Storage-Systeme (NAS... - SAN vs. NAS: Unterschied ...

„Big Data“ lässt grüßen! Laut einer Studie des Festplatten-Giganten Seagate soll sich der weltweit... - Online Banking Software: 4...

Wer Bankgeschäfte über das Internet erledigen möchte, muss dafür nicht zwingend über die Internets... - Ninite – das wohl nützlic...

System-Tools gibt es wie Sand am Meer. Die meisten versprechen viel und halten wenig. Wirklich gut... - Digitalisierung anpacken:...

Die Corona-Pandemie hat ohne Zweifel einen starken Beitrag zur Digitalisierung kleinerer und mitte...

populäre Artikel

- How to Check The Serial Number...

Buying a huawei watch can sometimes be a dream come true, especially if you have had b... - Synology DiskStation Manager

Der DiskStation Manager (DSM) ist das Betriebssystem für die Network Attached Storage-Systeme (NAS... - Online Banking Software: 4...

Wer Bankgeschäfte über das Internet erledigen möchte, muss dafür nicht zwingend über die Internets... - Einrichten einer lokalen...

Dieser Artikel richtet sich an alle Hobby-Webentwickler, die ihre erstellten Web-Projekte auf dem... - Digitalisierung anpacken:...

Die Corona-Pandemie hat ohne Zweifel einen starken Beitrag zur Digitalisierung kleinerer und mitte...

Lieblingsartikel

- SAN vs. NAS: Unterschied ...

„Big Data“ lässt grüßen! Laut einer Studie des Festplatten-Giganten Seagate soll sich der weltweit... - Online Banking Software: 4...

Wer Bankgeschäfte über das Internet erledigen möchte, muss dafür nicht zwingend über die Internets... - Ninite – das wohl nützlic...

System-Tools gibt es wie Sand am Meer. Die meisten versprechen viel und halten wenig. Wirklich gut... - Einrichten einer lokalen...

Dieser Artikel richtet sich an alle Hobby-Webentwickler, die ihre erstellten Web-Projekte auf dem...