Projekt Dojo: Teslas neuer Supercomputer kann 2022 in Betrieb gehen

Posted by Julia Werner •

Was müssen Supercomputer für das Exascale-Zeitalter können?

Intel Was müssen Supercomputer für das Exascale-Zeitalter können?

Supercomputer auf Basis von Intel-Prozessoren belegen 77 Prozent aller Einträge der jüngsten TOP500-Liste und stellen knapp 90 Prozent aller neuen Systeme des Jahres 2011. Wie sieht Intels Strategie beim Übergang vom Petascale- auf das Exascale-Computing aus?

Kirk Skaugen, Vice President und General Manager der Data Center Group von Intel, erläuterte im Rahmen der International Supercomputing Conference in Hamburg, wie das Unternehmen bis Ende dieses Jahrzehnts Leistungen im ExaFLOP/s-Bereich ermöglichen möchte. Mit einer Trillion Rechenoperationen pro Sekunde bedeutet ein ExaFLOP/s mehrere Hundertmal mehr Leistung als sie heutige Supercomputer bieten.

Um Exascale-Rechenleistung zu erreichen, sind neue Hardwareansätze wie Intels Many-Integrated-Core-(MIC-)Architektur notwendig. Wachsende Datenmengen verlangen nach kontinuierlich steigender Rechenleistung wie sie nur Supercomputer bieten können.

Die MIC-Architektur ergänzt bestehende Produkte wie Intels Xeon-Prozessoren und soll der Branche den Weg in das Zeitalter des Exascale-Computing ebnen. Das erste MIC-Produkt (Codename „Knights Corner“) soll auf Basis von Intels 22-nm-Technologie hergestellt werden, die über 3D-Tri-Gate-Transistoren verfügen. Intel liefert bereits MIC-Softwareentwicklungsplattformen (Codename „Knights Ferry“) an ausgewählte Partner.

„Bei den Supercomputern der TOP500-Liste sind unsere Xeon-Prozessoren erste Wahl“, so Skaugen, „mit der MIC-Architektur erweitern wir unser Engagement im High-Performance-Computing und bereiten diese Branche auf die kommenden Workloads im Peta- und Exascale-Bereich vor“.

Den Weg für Exaflop-Leistung bereiten

Skaugen beschrieb drei Vorraussetzungen, die den Schritt vom Petascale-Computing hin zur Ära des Exscale-Computings möglich machen können: Die Fortschreibung des Moore’schen Gesetzes, kombiniert mit einem neuartigen Modell zur Softwareprogrammierung sowie die hohe Skalierbarkeit der Systeme. Dieser Leistungszuwachs bedeutet aber auch einen Anstieg der Energieaufnahme.

So würde der derzeit schnellste Supercomputer in China, der Tianhe-1A, zum Erreichen von Exascale-Leistung mehr als 1,6 GW an Energie benötigen. Dies wäre ausreichend Energie, um zwei Millionen Haushalte mit Energie zu versorgen. Somit stellt sich hinsichtlich der Energieeffizienz eine enorme Herausforderung.

Intel und Forscher aus Europa haben drei europäische Labore eingerichtet, um sich dieser Herausforderung anzunehmen. Die Labore verfolgen das Ziel, die Relevanz des High-Performance-Computings in Europa zu nutzen sowie die Fähigkeiten in den Bereichen rechnergestützte Naturwissenschaften, Entwicklung und Strategic Computing auszubauen. Zudem sollen die Labore Simulationsanwendungen erstellen, um Exascale-Leistung im Bezug auf Energieeffizienz zu untersuchen.

High Performance Computing als Wachstumsmarkt

Laut Skaugen birgt der HPC-Markt ein immenses Wachstumspotenzial. Leisteten die Supercomputer der 80er Jahre noch GigaFLOP/s (Milliarden Fließkommaoperationen pro Sekunde), liefern die schnellsten Maschinen heute ein Millionenfaches dessen. Dadurch ist auch die Prozessor-Nachfrage im Supercomputing-Umfeld gestiegen.

Intel erwartet, dass die Top 100 der Supercomputer im Jahr 2013 eine Million Prozessoren verwenden werden. Bis 2015 soll sich diese Zahl verdoppeln und bis zum Ende des Jahrzehnts sogar auf acht Millionen ansteigen. Die Leistung des schnellsten TOP500-Computers wird im Jahr 2015 schätzungsweise bei 100 PetaFLOP/s liegen und die Grenze von einem ExaFLOP/s im Jahr 2018 durchbrechen.

Bis zum Ende des Jahrzehnts wird das schnellste System auf der Erde mehr als 4 ExaFLOP/s leisten.

Jetzt Newsletter abonnieren Verpassen Sie nicht unsere besten Inhalte Geschäftliche E-Mail Bitte geben Sie eine gültige E-Mailadresse ein. Abonnieren Mit Klick auf „Newsletter abonnieren“ erkläre ich mich mit der Verarbeitung und Nutzung meiner Daten gemäß Einwilligungserklärung (bitte aufklappen für Details) einverstanden und akzeptiere die Nutzungsbedingungen. Weitere Informationen finde ich in unserer Datenschutzerklärung. Aufklappen für Details zu Ihrer Einwilligung Stand vom 15.04.2021 Es ist für uns eine Selbstverständlichkeit, dass wir verantwortungsvoll mit Ihren personenbezogenen Daten umgehen. Sofern wir personenbezogene Daten von Ihnen erheben, verarbeiten wir diese unter Beachtung der geltenden Datenschutzvorschriften. Detaillierte Informationen finden Sie in unserer Datenschutzerklärung. Einwilligung in die Verwendung von Daten zu Werbezwecken Ich bin damit einverstanden, dass die Vogel Communications Group GmbH & Co. KG, Max-Planckstr. 7-9, 97082 Würzburg einschließlich aller mit ihr im Sinne der §§ 15 ff. AktG verbundenen Unternehmen (im weiteren: Vogel Communications Group) meine E-Mail-Adresse für die Zusendung von redaktionellen Newslettern nutzt. Auflistungen der jeweils zugehörigen Unternehmen können hier abgerufen werden. Der Newsletterinhalt erstreckt sich dabei auf Produkte und Dienstleistungen aller zuvor genannten Unternehmen, darunter beispielsweise Fachzeitschriften und Fachbücher, Veranstaltungen und Messen sowie veranstaltungsbezogene Produkte und Dienstleistungen, Print- und Digital-Mediaangebote und Services wie weitere (redaktionelle) Newsletter, Gewinnspiele, Lead-Kampagnen, Marktforschung im Online- und Offline-Bereich, fachspezifische Webportale und E-Learning-Angebote. Wenn auch meine persönliche Telefonnummer erhoben wurde, darf diese für die Unterbreitung von Angeboten der vorgenannten Produkte und Dienstleistungen der vorgenannten Unternehmen und Marktforschung genutzt werden. Falls ich im Internet auf Portalen der Vogel Communications Group einschließlich deren mit ihr im Sinne der §§ 15 ff. AktG verbundenen Unternehmen geschützte Inhalte abrufe, muss ich mich mit weiteren Daten für den Zugang zu diesen Inhalten registrieren. Im Gegenzug für diesen gebührenlosen Zugang zu redaktionellen Inhalten dürfen meine Daten im Sinne dieser Einwilligung für die hier genannten Zwecke verwendet werden. Recht auf Widerruf Mir ist bewusst, dass ich diese Einwilligung jederzeit für die Zukunft widerrufen kann. Durch meinen Widerruf wird die Rechtmäßigkeit der aufgrund meiner Einwilligung bis zum Widerruf erfolgten Verarbeitung nicht berührt. Um meinen Widerruf zu erklären, kann ich als eine Möglichkeit das unter https://support.vogel.de abrufbare Kontaktformular nutzen. Sofern ich einzelne von mir abonnierte Newsletter nicht mehr erhalten möchte, kann ich darüber hinaus auch den am Ende eines Newsletters eingebundenen Abmeldelink anklicken. Weitere Informationen zu meinem Widerrufsrecht und dessen Ausübung sowie zu den Folgen meines Widerrufs finde ich in der Datenschutzerklärung, Abschnitt Redaktionelle Newsletter.

(ID:27842410)

AMD kündigt neue „Instinct MI100“-GPU an und durchbricht die 10-TFLOPS-Grenze im FP64 -

Mit der wachsenden Nachfrage nach HPC- und KI-basierten Cloud-Anwendungen besteht ein Bedarf an sehr leistungsstarken Rechenzentrums-GPUs. NVIDIA ist im Allgemeinen der König auf diesem Gebiet, aber AMDs neueste MI100-GPU hat ernsthafte Konkurrenz.

Eine Karte für den HPC-Markt

Die Karte ist schnell, ernsthaft schnell. NVIDIAs High-End-A100-GPU erreicht bei FP9,7-Workloads einen Spitzenwert von 64 TFLOPS. Der neue „AMD Instinct MI100“ übertrifft den von 11,5 TFLOPS.

Natürlich unterstützen NVIDIA-Karten andere Beschleunigungstechniken für KI-spezifische Workloads in verschiedenen Zahlenformaten, wie das TensorFloat-32-Präzisionsformat und feinkörnige strukturierte Sparsamkeit. Bei KI- und Machine-Learning-Workloads ist NVIDIA immer noch König, da seine Boards speziell für Tensor-basierte Operationen entwickelt wurden.

Aber für Allzweck-Hochleistungsrechnen nimmt der MI100 die Krone der rohen Rechenleistung auf. Außerdem ist es fast die Hälfte des Preises und pro Watt viel effizienter.

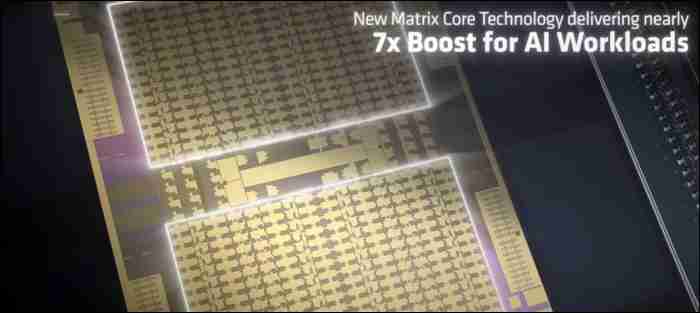

Zusätzlich zu den anderen Verbesserungen bringt die neue Architektur auch gemischte Präzisionsverbesserungen mit sich, wobei ihre „Matrix Core“-Technologie eine 16-mal bessere FP7-Leistung bietet als ihre vorherige Kartengeneration.

Die AMD- und Instinct-GPUs-Prozessoren treiben beide Exascale-Supercomputer des US-Energieministeriums an. Der Supercomputer „Frontier“ soll nächstes Jahr mit aktuellen Epyc- und MI100-Prozessoren gebaut werden und über 1,5 Exaflops Spitzenrechenleistung liefern. Der Supercomputer „El Capitan“ soll 2023 auf Hardware der nächsten Generation gebaut werden und mehr als 2 doppelt präzise Power-Exaflops liefern.

Kann ROCm mit CUDA mithalten?

Natürlich ist all diese Leistung nutzlos, wenn die Software sie nicht unterstützt. Es ist kein Geheimnis, dass es NVIDIA gelungen ist, maschinelles Lernen zu einem ummauerten Garten zu machen.

Das Compute-Framework von NVIDIA heißt CUDA oder Compute Unified Device Architecture. Es ist Besitzer und funktioniert nur mit ihren Karten. Da ihre Karten aber schon immer die schnellsten waren, werden viele Apps zunächst nur mit CUDA-Unterstützung erstellt.

Es gibt plattformübergreifende Programmiermodelle, darunter OpenCL, die AMD mit ihrer ROCm-Plattform sehr gut unterstützt. NVIDIA- und AMD-Karten unterstützen OpenCL, aber da NVIDIA dies nur durch die Übertragung auf CUDA unterstützt, ist es tatsächlich langsamer, OpenCL mit einer NVIDIA-Karte zu verwenden. Aus diesem Grund wird es nicht von allen Apps unterstützt.

Letztendlich müssen Sie selbst recherchieren und sehen, ob die App, die Sie ausführen möchten, auf AMD-Karten ausgeführt werden kann, und möglicherweise bereit sein, an Fehlern zu basteln und diese zu beheben. NVIDIA-GPUs hingegen sind meistens Plug-and-Play. Obwohl AMD schneller ist, kann NVIDIA sie dennoch mit Closed-Source-Software behindern.

Diese Situation verbessert sich jedoch – AMD ist bestrebt, alles zu öffnen und eine offene Umgebung zu schaffen. Tensorflow und PyTorch, zwei sehr beliebte ML-Frameworks, unterstützen beide das ROCm-Ökosystem.

Hoffentlich können die rohen Spezifikationen der neuesten Angebote von AMD die Branche zu einem wettbewerbsfähigeren Umfeld bewegen. Schließlich kommen sie in Supercomputern zum Einsatz

Projekt Dojo: Teslas neuer Supercomputer kann 2022 in Betrieb gehen

Tesla hat mit dem Projekt "Dojo" im Rahmen des "Tesla AI Day"-Events eine neue Supercomputer-Technologie genauer vorgestellt. Dabei geht es unter anderem auch um die firmeninterne Forschung an verbessertem Chipdesign, dem D1.

Dojo bekommt eine Kapazität von über einem Exaflop

Tesla behauptet dabei, die schnellste KI-Trainingsmaschine der Welt entwickelt zu haben. Ganz neu ist der Bereich für das Unternehmen nicht, denn Tesla hat schon vor einigen Jahren angekündigt, die Entwicklung eines neuen Supercomputers voranzutreiben, der für das Videotraining mit neuronalen Netzen optimiert ist.Dabei kommen die E-Fahrzeuge des Konzerns ins Spiel. Tesla verarbeitet eine riesige und stetig wachsende Menge an Videodaten aus seiner Flotte von mittlerweile über einer Million Fahrzeugen, die es zum Trainieren seiner neuronalen Netze verwendet. Allerdings gab es da bisher ein Problem - die verfügbare Hardware war für das Training der neuronalen Netze nicht optimal und Tesla grundlegend unzufrieden. Man glaubte, so schreibt das Online-Magazin Electrek , dass man das selbst intern besser machen könnte - und die ersten Ergebnisse sprechen für sich.Letztes Jahr hatte Tesla-Gründer Elon Musk angekündigt, dass Dojo eine Kapazität von über einem Exaflop haben würde, also eine Trillion (10^18) Floating-Point Operations pro Sekunde erreichen kann. Damit wäre Dojo der leistungsstärkste Supercomputer der Welt. Ganesh Venkataramanan, Teslas Senior Director of Autopilot-Hardware und Leiter des Dojo-Projekts, zeigte nun die Einzelheiten. Eine wichtige Basis des Projekts ist der D1-Chip von Dojo, der in 7-Nanometer-Technologie gefertigt wird und laut Tesla bahnbrechende Bandbreiten- und Rechenleistungen bietet.Tesla hat den Chip so konzipiert, dass er "nahtlos und ohne Klebstoff miteinander verbunden werden kann". Bei Dojo werden so 500.000 Knoten miteinander verbunden. Hinzu kommt die Schnittstelle, die Stromversorgung und das Wärmemanagement, und das Ergebnis ist eine sogenannte Trainingskachel. Eine Trainingskachel bietet 9 PFlops und 36 TB pro Sekunde Bandbreite in einem Format von weniger als einem Kubikfuß, also in etwa 0,03 Kubikmeter. Nun muss Tesla aber noch einen Computer-Cluster mit diesen Trainingskacheln bilden, um den ersten Dojo-Supercomputer zu bauen.Laut Tesla wird man dazu 2 x 3 Kacheln in einem Fach und zwei Fächer in einem Computerschrank kombinieren, um über 100 PFlops pro Schrank zu erreichen. In einem System mit zehn Schränken wird Teslas Dojo ExaPod die Grenze der ExaFlop-Rechenleistung durchbrechen - etwas, das die Hersteller von Supercomputern seit Langem zu erreichen versuchen. Wie Elon Musk behauptet, wird man wohl schon nächstes Jahr den Betrieb des Systems aufnehmen können.

Tagged:

Leave a Reply

neueste Artikel

- How to Check The Serial Number...

Buying a huawei watch can sometimes be a dream come true, especially if you have had b... - Synology DiskStation Manager

Der DiskStation Manager (DSM) ist das Betriebssystem für die Network Attached Storage-Systeme (NAS... - SAN vs. NAS: Unterschied ...

„Big Data“ lässt grüßen! Laut einer Studie des Festplatten-Giganten Seagate soll sich der weltweit... - Online Banking Software: 4...

Wer Bankgeschäfte über das Internet erledigen möchte, muss dafür nicht zwingend über die Internets... - Ninite – das wohl nützlic...

System-Tools gibt es wie Sand am Meer. Die meisten versprechen viel und halten wenig. Wirklich gut... - Digitalisierung anpacken:...

Die Corona-Pandemie hat ohne Zweifel einen starken Beitrag zur Digitalisierung kleinerer und mitte...

populäre Artikel

- How to Check The Serial Number...

Buying a huawei watch can sometimes be a dream come true, especially if you have had b... - Synology DiskStation Manager

Der DiskStation Manager (DSM) ist das Betriebssystem für die Network Attached Storage-Systeme (NAS... - Online Banking Software: 4...

Wer Bankgeschäfte über das Internet erledigen möchte, muss dafür nicht zwingend über die Internets... - Einrichten einer lokalen...

Dieser Artikel richtet sich an alle Hobby-Webentwickler, die ihre erstellten Web-Projekte auf dem... - Digitalisierung anpacken:...

Die Corona-Pandemie hat ohne Zweifel einen starken Beitrag zur Digitalisierung kleinerer und mitte...

Lieblingsartikel

- SAN vs. NAS: Unterschied ...

„Big Data“ lässt grüßen! Laut einer Studie des Festplatten-Giganten Seagate soll sich der weltweit... - Online Banking Software: 4...

Wer Bankgeschäfte über das Internet erledigen möchte, muss dafür nicht zwingend über die Internets... - Ninite – das wohl nützlic...

System-Tools gibt es wie Sand am Meer. Die meisten versprechen viel und halten wenig. Wirklich gut... - Einrichten einer lokalen...

Dieser Artikel richtet sich an alle Hobby-Webentwickler, die ihre erstellten Web-Projekte auf dem...