Tesla nutzt für Autopilot-Training fünftstärksten Supercomputer der Welt – und will noch mehr

Posted by Julia Werner •

GER 140:1: Supercomputer EuroHPC kommt mit Speicher satt

EU-Komissionspräsidentin Ursula von der Leyen hat eine europäische Offensive für die digitale Souveränität Europas und die Unabhängigkeit binärer Hoheitsrechte verkündet. Acht Milliarden Euro sollen dafür in den nächsten Jahren fließen. Entstehen werden mehrere Supercomputer an unterschiedlichen Standorten. Das Aushängeschild heißt Leonardo und wird von der EU in Italien mitfinanziert. 10 Exaflops, 3 PByte RAM und bis zu 300 PByte SSD-Kapazität sind die Eckdaten. Der Standort Deutschland spielt dabei erst mal keine Rolle.

Die Bedeutung von KI (künstliche Intelligenz), ML (Machine Learning) und Analytics ist auch in der europäischen Kommission angekommen. Mit einem stolzen Investment von acht Milliarden Euro will die EU die kontinentale Wirtschaft auf dem Weg der digitalen Transformation unterstützen, und damit auch unabhängig machen von Marktkräften und Technologien, etwa aus China oder den USA.

Dieses Projekt trägt den Namen EuroHPC, und High-Performance-Computing (HPC) über europäische Supercomputer-Zentren hinweg soll Wissenschaft, Forschung, aber auch die Wirtschaft stärken. Im September 2019 wurde verkündet, dass acht dieser Mammut-Rechner geplant sind. Für vier wurden nun Spezifikationen bekannt.

MeluXina (Luxemburg), EURO IT4I (Tschechien), IZUM (Slovenien) sind in der konkreteren Planungsphase, ebenso wie das größte geplante Projekt: Leonardo in Italien. Alle Systeme sollen auf NVIDIA -Architekturen basieren: Ampere-CPUs, A100-GPUs und HDR-Infiniband. HPE ist mit der Umsetzung in Tschechien beauftragt (wählt aber Lenovo-Hardware), die anderen Projekte übernimmt der französische Systembilder ATOS.

Leonardo ist die mit Abstand stärkste der geplanten vier Rechenfarmen und wird im Bologna Science Park für den italienischen Universitäts- und Forschungsbund CINECA entstehen. Der italienische Staat unterstützt den Bau mit 120 Millionen Euro, die EU steuert weitere 120 Millionen Euro bei. Der Supercomputer soll künftig Wettervorhersagen berechnen, den Klimawandel simulieren und an Krankheiten forschen. Aktuell natürlich auch an Covid-19 forschen. Die Industrie erhält unter anderem zur Materialforschung Zugriff. Es wird das rechenstärkste Computersystem Europas, weltweit unter den Top 10 eingeordnet.

Projekt EuroHPC: Die EU bringt für 8 Mrd. Euro mehrere Supercomputer an den Start (Bild: Canva)

Leonardo mit 10 Exaflops

Beim Leonardo-Projekt werden 5.000 Rechen-Nodes zusammengeschaltet. Während Atos in der Vergangenheit eher AMD verwendete, sollen nun Intel Xeon-Prozessoren herhalten. Ice Lake-SP mit PCI Express 4.0 erscheint wahrscheinlich, ist aber nicht bestätigt. Von den 5.000 Nodes sollen knapp 3.500 mit je vier A100-GPU-Beschleunigern arbeiten, insgesamt 14.000 A100-Einheiten. Zu den weiteren Spezifikationen gehören mindestens 3 Petabyte RAM, insgesamt bis zu 300 Petabyte Massenspeicher und ein 200-GBit/s-Interconnect der Nvidia-Tochter Mellanox. Die Systeme sollen 624 Tensor-FP16-TeraFlops pro GPU und 10 ExaFlops FP16-Rechenleistung erreichen.

Bis zum Baubeginn 2021 und vollständiger Inbetriebnahme 2022 gehen allerdings weitere Rechenfarmen mit noch mehr Leistung ans Netz. Aktuell nutzt Cineca Marconi-100 – mit knapp 22 FP64-PetaFlops derzeitig Platz 9 der Top500.

HPC – GER: 140:1

Die leistungsstärksten Rechenzentren in Deutschland finden sich in Jülich. Arbeitskräfte und hochspezialisierte IT-Nerds werden aber in Luxemburg, Finnland und Slowenien ihren neuen Job finden. Genau dort, wo der beauftragte IT-Dienstleister aus Frankreich, ATOS, schon Rechenzentren betreibt.

Gegen die acht Milliarden Gesamtinvestition sind 240 Millionen Euro für das größte Supercomputer-Zentrum Europas nahe Bologna fast schon ein Klacks, ein Fußballstadion kostet nicht mehr. Nun entsteht ein Supercomputer in Italien, dem in Deutschlands leistungsstärkstem Supercomputing-Rechenzentrum in Jülich nach der im Gange befindlichen Umstellung auf die Nvdia A100-Chips eine Performance von 1:140 im Vergleich zu Bologna steht. 120 Mio. zahlt der italienische Staat, der deutsche nicht.

Das Leonardo-Projekt wird neben Compute auf Basis von Nvidia A100-Chips und Infiniband anfänglich rund 150 PByte Speicherkapazität und 3 PByte RAM benötigen, dann bald 300 PByte und 5 PByte RAM.

Outscaling und DDN

Speicherseitig arbeitet Atos gemeinhin mit Storage von DDN. Für das Leonardo-Projekt ist dies nicht bestätigt, aber wahrscheinlich. Der hierzulande nicht so prominente Anbieter kommt aus dem Bereich des High-Performance-Storage, ursprünglich im Broadcasting.

Deutschland ist technologisch nicht dabei

Ist nach dem PC (Siemens vs. IBM), Video (VHS vs. Beta 3000), Teletext-Appliances und schließlich Mobiltelefoniegeräten (Siemens gegen alle), Cloud (Deutsche Telekom vs. globale Diverse), flächendeckendes High-Speed-Netzwerk (50 Mbit vs. 5G) nun Hyperscale das nächste Fiasko der deutschen »Neuland«-eStrategie? Es ist zu befürchten…

Deutsche Steuerzahler investieren im Rahmen der EU. Damit entsteht in Italien ein Supercomputer, dem in Deutschland nichts standhalten kann. Wir haben bei der EU-Präsidentin Ursula von der Leyen nachgefragt, warum dieser Invest für Deutschland dennoch Sinn macht. Noch warten wir auf Antwort.

Perlmutter drängt sich in die Liste der schnellsten Superrechner

Top500 hat seine aktuelle Liste der 500 leistungsstärksten Superrechner der Welt veröffentlicht. Viel änderte sich im vergangenen Halbjahr seit der letzten Liste nicht. Die Top 10 hat jedoch einen neuen Eintrag: Perlmutter.

Perlmutter ist ein System des National Energy Research Scientific Computing Center am Lawrence Berkeley National Laboratory in Kalifornien. Der Superrechner basiert auf der Shasta-Plattform von HPE Cray. Der Supercomputer-Hersteller Cray gehört seit der Übernahme in 2019 zu HPE. Lesen Sie hier mehr zu der Milliardenübernahme.

Der Neuling in den Top 10: Perlmutter. (Source: NERSC)

64,6 Petaflops mit GPU- und CPU-Rechenknoten

Der Neuling in der Top500-Liste ist ein heterogenes System, das sowohl GPU-beschleunigte als auch reguläre CPU-Rechenknoten einsetzt. Zusammen erzielen die Rechenknoten eine maximale Leistung von 64,6 Petaflops - also fast 65 Billiarden Gleitkommaoperationen pro Sekunde, die Masseinheit für die Leistungsfähigkeit von Computern.

Diese beeindruckende Leistung entspricht trotzdem nur rund 15 Prozent der Rechenleistung des erstplatzierten Rechners: der japanische Supercomputer Fugaku. Das Fujitsu-System erreicht 442 Petaflops. Somit deklassiert es sogar die Nummer 2 auf der Liste, der US-amerikanische Superrechner Summit mit seinen 148,8 Petaflops.

Die unangefochtene Nummer 1: Fugaku. (Source: Fujitsu)

Die Spitzenleistung des Fujitsu-Systems liegt sogar über einem Exaflop - also über eine Trillion Gleitkommaoperationen pro Sekunde. Aus diesem Grund wird Fugaku gelegentlich auch als der erste Exascale-Supercomputer bezeichnet.

Tesla stellt eigenen Exascale-Rechner vor

Der US-amerikanische Autohersteller Tesla stellte in derselben Woche seinen eigenen Exascale-Superrechner vor - fast. In einer Videokonferenz gab Andrej Karpathy, Teslsa KI-Chef, einen Einblick in die Forschung rund um die Autopilot-Software des Herstellers. Dafür nutzt das Unternehmen gemäss Karpathy einen Superrechner mit einer Leistung von 1,8 Exaflops.

Firmenrechner werden zwar nicht auf die Top500-Liste aufgenommen. Karpathy sagte allerdings, dass der Supercomputer wohl der fünftschnellste der Welt sei - trotz der Exaflops-Leistung. Denn wenn man die Genauigkeit berücksichtigt, kommt man auf eine Leistung von 112 Petaflops, wie Teslamag.de nachgerechnet hat. Die Genauigkeit bezeichnet die Anzahl der Bytes, mit der eine Zahl verarbeitet wird. Je grösser die Zahl wird, desto mehr Bytes hat sie und desto länger braucht die Berechnung.

Und wo ist die Schweiz auf der Top500-Liste? In der aktuellen Auflistung ist das Land mit 3 Rechnern vertreten. Der Höchstplatzierte ist Piz Daint, der vom 12. auf den 15. Platz abgerutscht ist. Der schnellste Schweizer und viertschnellste europäische Rechner erreicht über 21 Petaflops.

Piz Daint wird ersetzt

Im Sommer 2017 war Supercomputer im Nationalen Hochleistungszentrum der Schweiz (CSCS) in Lugano sogar mal die Nummer 3 weltweit, wie Sie hier nachlesen können. Erst im November 2020 fiel er aus der Top 10 heraus.

Der Piz Daint im Nationalen Hochleistungszentrum der Schweiz (CSCS) in Lugano. (Source: Copyright: Contact:

Der Piz Daint soll nun durch das Alps-System ersetzt werden. Der neue Superrechner auf Basis der neuen Cray-EX-Supercomputer-Produktlinie soll 2023 vollständig in Betrieb sein. Um es in die Top 10 zu schaffen, muss Alps (derzeit auf Platz 136) eine höhere Rechenleistung erzielen, als sie Piz Daint jemals hatte. Denn die aktuelle Nummer 10 schafft bereits fast 24 Petaflops.

Lesen Sie hier mehr zur Pensionierung des Piz Daint. Und wie die Pläne für den neuen Supercomputer aussehen, lesen Sie hier im Interview mit CSCS-Direktor Thomas Schulthess.

Tesla nutzt für Autopilot-Training fünftstärksten Supercomputer der Welt – und will noch mehr

Die ambitionierten Ankündigungen kommen von CEO Elon Musk auf Twitter, und mit mehr technischen Informationen zum Autopilot-System von Tesla meldet sich gelegentlich sein KI-Chef Andrej Karpathy zu Wort. Wie er vor kurzem mit einer interessanten Formulierung wissen ließ, hält auch Karpathy Computer für grundsätzlich besser geeignet als Menschen, die schwierige Aufgabe des Autofahrens zu meistern. Und bei einem Vortrag auf einer virtuellen KI-Konferenz zeigte er jetzt unter anderem, mit wie viel Rechenpower Tesla ihnen das beibringen will.

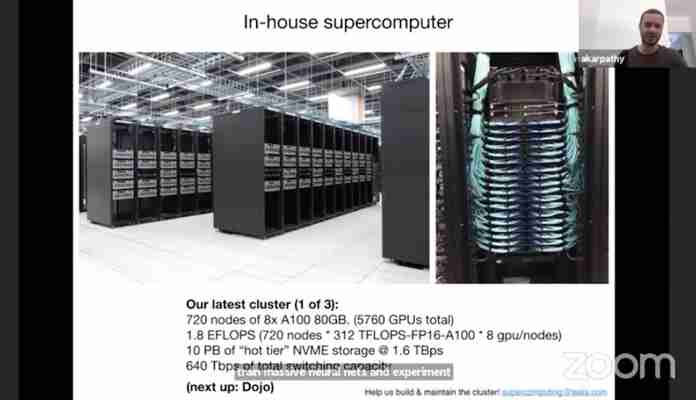

Tesla-Supercomputer mit 1,8 Exaflops

In dem Vortrag ging es nicht um den FSD-Computer, der in den Elektroautos von Tesla Daten der Sensoren entgegennimmt und in Fahrbefehle umsetzt, sondern um die stationäre Maschine, mit denen das Unternehmen die darauf laufenden neuronalen Netze trainiert. Laut Karpathy handelt es sich bei deren neuester Version um einen Cluster aus 720 Knoten mit jeweils acht A100-Prozessoren von Nvidia (s. Foto oben). Diese Chips sind für Berechnungen mit künstlicher Intelligenz optimiert. Zusammen sollen sie auf 1,8 Exaflops kommen, was den Tesla-Supercomputer nach Angaben von Karpathy zum fünftschnellsten der Welt machen dürfte.

„Als Nächstes: Dojo“, deutet die von Karpathy aufgelegte Computer-Folie außerdem schon den nächsten geplanten Schritt an: Zum ersten Mal im Frühjahr 2019 erwähnte CEO Musk einen selbst entwickelten KI-Trainingscomputer namens Dojo zur Auswertung von riesigen Mengen Video-Daten. Im August 2020 nannte er eine geplante Rechenleistung von 1 Exaflops, was mehr sein sollte als bei jedem anderen staatlichen oder privaten Rechner weltweit. Wenn die aktuelle Angabe von Karpathy von 1,8 Exaflops vergleichbar ist, dürfte das bedeuten, dass dieser ehrgeizige Wert schon wieder überholt ist und Tesla noch mehr anstrebt.

Dass Dojo noch kommen solle, bestätigte Karpathy in seinem Zoom-Vortrag. Nähere Informationen zu diesem Thema hatte er nicht, warb aber um neue Mitglieder für den Aufbau des Teams dafür. Nur allgemein sagte der KI-Chef zum Dojo-Computer, dieser solle beim Trainieren neuronaler Netze noch leistungsfähiger sein als der aktuelle Super-Cluster bei Tesla. CEO Musk hat dazu schon angekündigt, Dojo möglicherweise später auch anderen Unternehmen zur Verfügung zu stellen – das wäre sozusagen der Tesla-Einstieg ins Cloud-Geschäft.

KI-Chef erklärt Verzicht auf Radar

Außerdem stellte sich Karpathy erneut hinter den von Tesla neuerdings vertretenen Ansatz „pure vision“ für die Autopilot-Sensorik, nur noch Kameras also. Model 3 und Model Y werden seit kurzem in den USA tatsächlich ohne Radar ausgeliefert. Unter anderem das bei Autopilot-Nutzern wohlbekannte Problem der plötzlichen „Phantom“-Bremsungen ohne erkennbaren Grund erklärte Musks KI-Mann mit der bisherigen Kombination aus Radar und Kameras: Der Radar-Sensor melde ständig stehende Objekte im Weg, und wenn die Bilder-Auswertung eines nur ansatzweise bestätige, könne das schon für eine unnötige Bremsung zum Beispiel unter einer Überführung sorgen. Um das zu ändern, könne man auch den Radar-Aspekt verbessern, aber das sei an sich nicht nötig, weil allein die Kamera-Daten genügend Informationen liefern würden, sagte Karpathy.

Tagged:

Leave a Reply

neueste Artikel

- How to Check The Serial Number...

Buying a huawei watch can sometimes be a dream come true, especially if you have had b... - Synology DiskStation Manager

Der DiskStation Manager (DSM) ist das Betriebssystem für die Network Attached Storage-Systeme (NAS... - SAN vs. NAS: Unterschied ...

„Big Data“ lässt grüßen! Laut einer Studie des Festplatten-Giganten Seagate soll sich der weltweit... - Online Banking Software: 4...

Wer Bankgeschäfte über das Internet erledigen möchte, muss dafür nicht zwingend über die Internets... - Ninite – das wohl nützlic...

System-Tools gibt es wie Sand am Meer. Die meisten versprechen viel und halten wenig. Wirklich gut... - Digitalisierung anpacken:...

Die Corona-Pandemie hat ohne Zweifel einen starken Beitrag zur Digitalisierung kleinerer und mitte...

populäre Artikel

- How to Check The Serial Number...

Buying a huawei watch can sometimes be a dream come true, especially if you have had b... - Synology DiskStation Manager

Der DiskStation Manager (DSM) ist das Betriebssystem für die Network Attached Storage-Systeme (NAS... - Online Banking Software: 4...

Wer Bankgeschäfte über das Internet erledigen möchte, muss dafür nicht zwingend über die Internets... - Einrichten einer lokalen...

Dieser Artikel richtet sich an alle Hobby-Webentwickler, die ihre erstellten Web-Projekte auf dem... - Digitalisierung anpacken:...

Die Corona-Pandemie hat ohne Zweifel einen starken Beitrag zur Digitalisierung kleinerer und mitte...

Lieblingsartikel

- SAN vs. NAS: Unterschied ...

„Big Data“ lässt grüßen! Laut einer Studie des Festplatten-Giganten Seagate soll sich der weltweit... - Online Banking Software: 4...

Wer Bankgeschäfte über das Internet erledigen möchte, muss dafür nicht zwingend über die Internets... - Ninite – das wohl nützlic...

System-Tools gibt es wie Sand am Meer. Die meisten versprechen viel und halten wenig. Wirklich gut... - Einrichten einer lokalen...

Dieser Artikel richtet sich an alle Hobby-Webentwickler, die ihre erstellten Web-Projekte auf dem...