Wo liegt der Unterschied zwischen Artificial Intelligence, Machine Learning und Deep Learning?

Posted by Julia Werner •

Was muss Hardware für KI, Machine und Deep Learning können?

Viele Unternehmen sehen sich mit einer Flut an Daten konfrontiert. Ihre gegenwärtige Technik im Rechenzentrum muss einen endlosen Strom an Telemetrie aus Maschinen, Anwendungen und Sensoren laufend verarbeiten und analysieren und hat damit häufig Schwierigkeiten. Gerade unstrukturierter Daten haben sich für traditionelle Informationssysteme, die auf strukturierten Datenbanken basieren, als besonders herausfordernd erwiesen.

In der Folge entwickelten Anbieter neue Algorithmen auf der Grundlage des Machine und Deep Learning (ML und DL). Um diese anzuwenden, müssen Unternehmen jedoch erst Systeme und Infrastruktur anschaffen, die für maschinelles Lernen, Deep Learning und KI-Workloads (künstliche Intelligenz) geeignet sind.

Das Interesse von Unternehmen and KI-Anwendungen ist sprunghaft angestiegen. Das liegt an der Verknüpfung von geometrisch expandierenden unstrukturierten Datensätzen, umfangreicher Forschung im Bereich des Machine und Deep Learnings sowie exponentiell leistungsfähigerer Hardware für die Parallelisierung und Beschleunigung der zugehörigen Workloads. IDC prognostiziert, dass KI bis 2024 weit verbreitet sein und von drei Vierteln aller Organisationen genutzt wird, wobei 20 Prozent der Arbeitslasten und 15 Prozent der Unternehmensinfrastruktur auf KI-basierte Anwendungen entfallen.

KI-Anwendungen sind ressourcenhungrig Unternehmen werden viele dieser Anwendungen in der Cloud aufbauen und dabei ML- und DL-Dienste wie AWS SageMaker oder Azure Cognitive Services nutzen. Doch das ist nur eine Option: Die gewaltige Datenmenge, die für das Training und den Betrieb solcher Algorithmen erforderlich ist und die hohen Kosten für Transfers zur und Speicher in der Cloud, zusammen mit dem Bedarf für Echtzeitergebnisse bedeuten, dass viele KI-Systeme von Unternehmen auf privaten, dedizierten Systemen laufen müssen. Historische Daten für das AI- und ML-Modelltraining und ständig eingehende Datenströme für das Überarbeiten von Modellen sowie prädiktive Analysen belegen Unsummen an Speicherkapazität. Datensätze für künstliche Intelligenz können Hunderte von Terabyte bis Petabyte erreichen und liegen typischerweise in unstrukturierten Formaten wie Text, Bild, Audio und Video vor, umfassen aber auch semistrukturierte Inhalte wie Web-Clickstreams und Systemprotokolle. Aus diesem Grund eignen sich für diese Daten Objektspeicher oder NAS-Dateisysteme (Network Attached Storage). Bei der Vorbereitung auf eine Zukunft mit verstärktem KI-Einsatz muss sich die IT mit vielen Architektur- und Bereitstellungsoptionen auseinandersetzen. Dazu gehören vor allem das Design und die Spezifikation von KI-beschleunigten Hardware-Clustern. Eine vielversprechende Option sind aufgrund ihrer Dichte, Skalierbarkeit und Flexibilität hyperkonvergente Infrastruktursysteme (hyper-converged Infrastructure, HCI). Hardware, die spezifisch für den Betrieb von KI-Anwendungen designt wurde, weist häufig viele Gemeinsamkeiten mit hyperkonvergenter Hardware auf.

KI-Anforderungen und Hardwarekernelemente Algorithmen für Machine und Deep Learning benötigen Daten zum Lernen. Das Auswählen, Erfassen und Vorverarbeiten dieser Daten mit Filtern, Kategorien und Merkmalsextraktion, ist elementar für die Genauigkeit und den Aussagewert der Ergebnisse eines Modells. Daher sind die Datenaggregation – also das Konsolidieren von Daten aus mehreren Quellen – und der Speicher die zentralen Elemente, bei denen KI-Anwendungen besondere Ansprüche an die IT-Infrastruktur stellen. Die Ressourcen für Speicher und Rechenleistung skalieren in der Regel nicht in gleichem Maße. Deshalb sollte hier die Wahl eher auf Systeme fallen, bei denen sich beide entkoppelt voneinander erweitern lassen, wobei lokaler Speicher für einen KI-Berechnungsknoten groß und schnell genug sein sollte, um einen Algorithmus zu bedienen.

Beliebte Infrastruktur für maschinelles Lernen und KI-Anwendungsfälle Die meisten KI-Systeme laufen auf Linux-VMs (virtuelle Maschine) oder als Docker-Container. Tatsächlich sind die meisten populären KI-Entwicklungsframeworks und viele Beispielanwendungen als vorgefertigte Container-Images von Nvidia und anderen Anbietern erhältlich. Beliebte Anwendungen umfassen: Maschinelles Sehen (Machine Vision) wie Bildklassifizierung, Objekterkennung (entweder in Bildern oder Videos), Bildsegmentierung und Bildrestaurierung,

Verarbeitung von Sprache und natürlicher Sprache (Natural Language Processing, NLP), Spracherkennung und Sprachübersetzung,

Text-zu-Sprache-Synthese,

Systeme für Empfehlungen, die Bewertungen und vorgeschlagene, personalisierte Inhalte oder Produkte auf der Grundlage früherer Benutzeraktivitäten und Referenzen bereitstellen,

Inhaltsanalyse, Filter und Moderation, und

Mustererkennung und Anomalieerkennung. Diese finden in einer Vielzahl von Branchen Anwendung, zum Beispiel: Betrugsanalyse und automatisierte Handelssysteme für Finanzdienstleistungsunternehmen,

Online-Personalisierung im Einzelhandel und Produktempfehlungen,

Überwachungssysteme für physische Sicherheit für Unternehmen, und

geologische Analysen für die Ressourcengewinnung durch Gas-, Erdöl- und Bergbauunternehmen. Einige Anwendungen, wie zum Beispiel das Aufspüren von Anomalien in der Cybersicherheit und Automatisierung im IT-Betrieb (AIOps), erstrecken sich über verschiedene Branchen, wobei KI-basierte Funktionen in verschiedene Verwaltungs- und Überwachungsprodukte integriert sind. Algorithmen für Machine und Deep Learning erfordern eine große Anzahl von Matrix-Multiplikations- und Akkumulations-Gleitkommaoperationen. Sie können Matrixberechnungen parallel durchführen. In dieser Hinsicht ähneln ML und DL Grafikfunktionen wie Pixelschattierung und Raytracing, die in Grafikprozessoren (Graphics Processing Unit, GPU) schneller ablaufen. Im Gegensatz zu CGI-Grafiken erfordern ML- und DL-Berechnungen jedoch oft keine doppelte (64-Bit) oder einfache (32-Bit) Genauigkeit. Das ermöglicht eine weitere Leistungssteigerung, indem die Anzahl der in den Berechnungen verwendeten Fließkomma-Bits verringert wird. Während die frühe Deep-Learning-Forschung für fast ein Jahrzehnt handelsübliche GPUs verwendet hat, gibt es mittlerweile separate Produktlinien von GPUs für Rechenzentren, zum Beispiel von Nvidia, die auf wissenschaftliche und KI-Workloads zugeschnitten sind.

Abbildung 1: Die interne Logik und das physische Design eines typischen KI-Servers

KI: Code schreiben wie Menschen – inklusive Fehler

Erste Programme zeigen: KI kann Code wie Menschen schreiben. Doch dabei entstehen auch unerwartete Fehler und neue Probleme.

Künstliche Intelligenz hat in den vergangenen Jahren große Fortschritte gemacht. KIs können nicht nur unsere Haushaltsgeräte steuern. Sie können auch Musik komponieren, unsere Autos (teilweise) fahren und sogar Gehirnströme in Sprache übersetzen.

Es überrascht daher nicht, dass viele Unternehmen mit immer neuen KI-Funktionen experimentieren. Eine davon: KI soll selbstständig Code schreiben können.

KI: Code schreiben hilfreich, aber auch fehlerhaft

Erste Software-Entwickler:innen experimentieren mit derartigen Programmen. Eines der bekanntesten Beispiele dafür ist das Programm „Copilot“ von Github. Github ist auf die Entwicklung von Software spezialisiert und gehört seit 2018 zu Microsoft.

Bei Copilot geben Programmierer:innen die ersten Zeilen an Code ein. Die KI kann dann erraten, um was es sich für ein Programm handeln soll und schreibt daraufhin den restlichen Code. Copilot beruht auf einem KI-Programm des Unternehmens Open AI und soll Coder bei Github entlasten.

Erste Erfahrungen zeigen, dass Copilot durchaus hilfreich ist und Zeit spart, gleichzeitig aber auch neue Probleme schafft. So ist Copilot nicht fehlerfrei. Ganz im Gegenteil.

KI und Menschen machen unterschiedliche Fehler

Alex Naka ist Datenwissenschaftler bei Github und arbeitet seit einiger Zeit mit Copilot. Er hat nicht nur festgestellt, dass die KI, genau wie auch Menschen, Fehler in den Code einbaut. Naka fand es darüber hinaus schwieriger, diese Fehler zu finden, wie er gegenüber dem Magazin Wired berichtet.

„Es gab einige Male, in denen ich einige unterschwellige Fehler übersehen habe, wenn ich einen der Vorschläge akzeptiert habe“, sagt Naka. „Und es kann sehr schwierig sein, diese auszumachen, vielleicht weil die KI andere Fehler macht, als ich sie gemacht hätte.“

Sicherheit: In 40 Prozent der Fälle fehlerhafter Code

Naka ist kein Einzelfall. Eine Studie der New York University hat sich ausführlich mit Copilot beschäftigt und dabei festgestellt, dass die KI bei Sicherheitsfeatures in rund 40 Prozent der Fälle Fehler macht.

Das liege oftmals daran, dass eine Codezeile falsch interpretiert wird oder der KI ein genauerer Kontext fehlt, der vorher nicht mit einprogrammiert wurde, heißt es in der Untersuchung.

Brendan Dolan-Gavitt, einer der Verfasser der Copilot-Studie, hat zudem festgestellt, dass die KI aus Versehen eine Reihe von verbotenen, beleidigenden Begriffen mit in den Code eingebaut hatte. Offenbar sind das die Begriffe, die das Programm vermeiden sollte.

While I wait for the GPU to churn through 2*26^11 possibilities, a brief recap of how we got here. It started when I noticed this bit of code in the @GitHubCopilot Visual Studio Code extension that detects naughty words in either the prompt or the suggestions. — Brendan Dolan-Gavitt (@moyix) September 2, 2021

Oege de Moor wiederum, der Copilot für Github mitentwickelt hat, betont, dass diese Fehlerquote sich nur auf eine Unterkategorie des gesamten Codes beziehe – und zwar auf eine Kategorie, in der Fehler wahrscheinlicher seien.

Oege de Moor verweist außerdem auf „CodeQL“, eine Art Rechtschreibprüfung für Copilot, die er ebenfalls entwickelt hat. CodeQL kann Programmierfehler innerhalb von Copilot aufdecken, weshalb de Moor empfiehlt, die beiden Programme gemeinsam zu nutzen.

Riesiges Marktpotenzial

Github ist natürlich nicht das einzige Unternehmen, das KI nutzt, um Code zu schreiben. Denn die Technologie hat großes Potenzial. 2020 lag der Marktwert von Künstlicher Intelligenz bei 35,92 Milliarden US-Dollar. Analysen zeigen zudem, dass der KI-Markt bis 2028 sogar auf einen Wert von 360,36 Milliarden US-Dollar wachsen könnte.

Dennoch sind einige Entwickler:innen noch sehr skeptisch. Sie befürchten, dass die Art und Weise wie KIs Code schreiben, eigentlich nur auf dem Abschreiben anderer Programme beruht. Eine Praxis, die die Tech-Gemeinschaft eigentlich ausrotten möchte.

LinkedIn-Guide gratis! Melde dich jetzt für unseren wöchentlichen Newsletter BT kompakt an. Als Dank schenken wir dir unseren LinkedIn-Guide.

Andere machen sich zudem Sorgen um die Sicherheit von Programmen, die von KIs geschrieben wurden. Denn wenn der Code auf existierenden Codes basiert, macht es dies für Hacker sehr viel leichter, sich in die Programme einzuschleusen und Malware zu platzieren.

KI-Entwickler de Moor dagegen glaubt an die Zukunft der Programme. Er gibt zwar zu, dass es noch viel zu verbessern gibt. Doch er glaubt auch, dass KIs beim Code schreiben noch am Anfang stehen und schon sehr bald kaum noch Fehler machen werden.

Auch interessant:

Wo liegt der Unterschied zwischen Artificial Intelligence, Machine Learning und Deep Learning?

Artificial Intelligence (AI) ist die Zukunft, ist Science Fiction und längst Teil unseres täglichen Lebens. All diese Aussagen treffen zu, denn es kommt darauf an von welcher Art AI man spricht.

Als zum Beispiel Google DeepMind’s AlphaGo den Meister im Brettspiel “Go”, Lee Se-Dol, besiegte, wurden die Begriffe AI, Machine Learning und Deep Learning immer wieder in den Medien genannt, um Google DeepMind zu beschreiben. Alle drei Technologien haben dazu beigetragen, dass AlphaGo Lee Se-Dol besiegen konnte; dennoch unterscheiden sie sich.

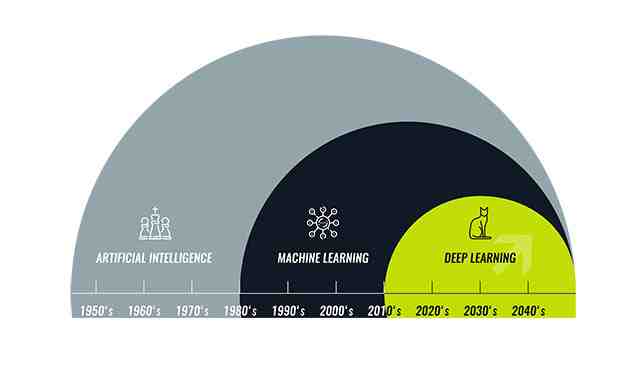

Der einfachste Weg um ihre Beziehung zueinander darzustellen ist ein konzentrischer Kreis. Dabei ist AI die erste und größte Idee, danach folgte Machine Learning und zu guter Letzt treibt Deep Learning die Entwicklung von AI und Machine Learning weiter voran.

Artificial Intelligence ist bereits Teil der menschlichen Vorstellung seit Computerspezialisten den Begriff auf der Dartmouth Conference 1956 das erste Mal vorstellten und somit das Gebiet der AI geboren haben. Seitdem wird prophezeit, dass AI der Schlüssel zur neuen und besseren Zukunft der Menschheit ist.

In den letzten Jahren ist AI nahezu explodiert, besonders seit 2015. Das liegt an der weiten Verfügbarkeit von GPUs. Sie ermöglichen eine schnelle, günstige und starke parallele Verarbeitung. Ebenso spielt die Kombination aus unendlich großen Speicher und Datenmengen eine große Rolle.

Eine einfache Idee von Computerspezialisten konnte sich so 2015 zum Boom entwickeln. Aus diesem Boom sind Anwendungen entstanden, die jeden Tag von hundert Millionen Menschen genutzt werden.

Artificial Intelligence - Maschinen weisen menschliche Intelligenz auf

Computerprogramme die Dame spielten sind eines der frühesten Beispiel für Artificial Intelligence. Auf der Dartmouth Konferenz im Sommer 1956 war es die Idee der AI Pioniere eine komplexe Maschine zu konstruieren, die mit Hilfe der neu entstehenden Computer, die gleiche Intelligenz wie ein Mensch besitzt. Bei diesem Konzept spricht man von der “General AI”: Maschinen, die all unsere Sinne haben, unsere Vernunft und so denken wie wir.

Was heute schon davon umgesetzt werden kann ist ein Konzept der “begrenzten AI”. Technologien die in der Lage sind spezifische Aufgaben genauso gut oder besser als Menschen zu lösen. Ein Beispiel dafür ist die Gesichtserkennung von Facebook oder die Bildklassifizierung bei Pinterest.

Die Technologien zeigen Aspekte von menschlicher Intelligenz. Doch wie funktioniert das und woher kommt die Intelligenz? Hier kommt Machine Learning ins Spiel.

Machine Learning - Ein Ansatz um Artificial Intelligence zu erreichen

Machine Learning ist im Grunde ein Verfahren das einen Algorithmus nutzt um Daten zu analysieren, von den Daten zu lernen und darüber eine Aussage oder Vorhersage zu treffen. Anders als Software die von Hand programmiert wurde und durch spezielle Anweisungen Aufgaben erfüllte, wird die Maschine durch den Gebrauch von großen Datenmengen und Algorithmen trainiert. Dies ermöglicht ihr zu lernen, wie eine Aufgabe ausgeführt werden muss.

Die Idee zu Machine Learning entstammt der frühen AI Experten. Der Algorithmus hat sich in den letzten Jahren weiterentwickelt, unter anderem umfasst er Entscheidungsbäume, induzierte Logikprogramme, Clustering, Verstärkungslernen und Bayes’sche Netze. Doch keiner erreichte das Ziel einer “General AI” und auch “begrenzte AI” war mit frühen Machine Learning Ansätzen nur schwer zu erreichen.

Es stellte sich heraus, dass eines der besten Anwendungsgebiete für Machine Learning das Programm ComputerVision war. Dennoch wurde eine Großteil an manuellen Programmierung benötigt, damit das Machine Learning funktionieren konnte. Programmierer schrieben Classifiers wie Edge Detection Filters. Das Programm konnte nun herausfinden, wo Objekte anfingen und wo sie endeten, die Form eines Objekts und die Buchstaben STOP erkennen. Daraus entwickelte sich ein Algorithmus der Bilder erkannte und lernte, was ein Stoppschild ist. Soweit eine gute Idee, doch an Tagen, an denen es beispielsweise sehr neblig war oder Bäume das Schild teilweise bedeckten, konnte der Algorithmus nur selten das Schild identifizieren. Dies war der Grund warum ComputerVision und Bilderkennung bis dato kaum Beachtung fanden. Erst heute machen die richtigen Lern-Algorithmen den Unterschied.

Deep Learning – Die Technik, um machine Learning zu implementieren

Das Heraussuchen von Katzenbildern auf YouTube war eine der ersten erfolgreichen Demonstrationen von Deep Learning.

Artificial Neural Networks wird von der Biologie und den Abläufen unseres Gehirns inspiriert. Doch im Gegensatz zum Gehirn, in dem Neuronen sich mit jedem beliebigen Neuron in einer bestimmten physischen Entfernung verbinden kann, kann das neuronale Netzwerk dies nur über separate Ebenen, Verbindungen und Richtungen der Datenausbreitung.

Nehmen Sie beispielsweise ein Bild und zerschneiden Sie es in einen Haufen Teile. Diese werden in die erste Ebene des neuronalen Netzwerks erfasst. In dieser ersten Ebene geben individuelle Neuronen die Daten an die zweite Ebene weiter. In der zweiten Ebene wird dieser Prozess wiederholt bis ein finales Ergebnis produziert wird.

Jedes Neuron weist seiner Eingabe eine Bewertung zu, ob dies korrekt oder falsch ist hängt im wesentlichen von der Aufgabe ab, die ausgeführt werden soll. Das finale Ergebnis wird dann durch die gesamten Bewertungen bestimmt. Denken Sie zurück an das Stoppschild-Beispiel. Eigenschaften eines Stoppschild-Bildes werden zerschnitten und von unterschiedlichen Neuronen geprüft – die achteckige Form, die rote Farbe, die markanten Buchstaben, die Größe. Die Aufgabe der Neuronen ist es herauszufinden, ob es ein Stoppschild ist oder nicht. Das neuronale Netzwerk gibt eine Wahrscheinlichkeits-Vektor aus, welcher sich auf die Bewertungen beruft. Im Beispiel mit dem Stoppschild könnte das System zu dem Entschluss kommen, dass es zu 86 Prozent ein Stoppschild ist, zu sieben Prozent eine Geschwindigkeitsanzeige, zu fünf Prozent ein Objekt das im Baum steckt und immer so weiter. Der Netzwerk-Architekt gibt dem System dann die Rückmeldung, was richtig ist und was nicht.

Neuronale Netzwerke gibt es bereits seit den Anfängen von AI, das Problem war, dass sie sehr rechenintensiv und dadurch praktisch nicht umzusetzen waren. Eine kleine Forschungsgruppe der Universität von Toronto, unter der Leitung von Geoffrey Hinton, arbeitet weiter an dem Konzept doch erst mit der Entwicklung der GPUs konnten sie die Funktion beweisen.

Nimmt man noch einmal das Beispiel Stoppschild. Das System wird zu Beginn oft die falsche Antwort auswerfen, denn es braucht Training. Wahrscheinlich muss das System hunderttausende oder Millionen Bilder sehen, bis die Bewertung so ausgereift ist, dass das Ergebnis immer richtig ist.

Das Deep Learning hatte seinen Durchbruch mit dem Informatiker Andrew Ng. Er vergrößerte das neuronale Netzwerk, steigerte die Ebenen und Neuronen und ließ dann eine große Menge an Daten in das System einspielen um es zu trainieren. Das “Deep” in Deep Learning steht also für die große Anzahl an Ebenen.

Heutzutage ist die Bilderkennung durch trainierte Maschinen bei einigen Szenarien schon besser als der Mensch. Ein Einsatzgebiet ist etwa die Identifikation von Indikatoren für Krebs im Blut oder Tumore auf MRT-Aufnahmen. Auch Google’s AlphaGo hat das Brettspiel gelernt, indem es das neuronale Netzwerk trainiert und immer wieder gegen sich selbst spielte.

Dank Deep Learning hat AI eine erfolgreiche Zukunft

Deep Learning ermöglicht viele praktische Anwendungen von Machine Learning und Erweiterungen des Felds der AI. Deep Learning bewältigt nahezu alle Aufgaben, so dass jegliche Art von maschineller Assistenz möglich erscheint.

Autonome Fahrzeuge, präventives Gesundheitswesen, Filmempfehlungen Artificial Intelligence ist die Gegenwart und die Zukunft. Mit Hilfe von Deep Learning kann AI zu der Science Fiction werden, die Sie sich bisher nur vorgestellt haben.

Wollen auch Sie vom Einsatz von Artificial Intelligence, Machine Learning und Deep Learning profitieren? Sprechen Sie uns an! Unsere Experten beraten Sie gerne.

Tagged:

Leave a Reply

neueste Artikel

- How to Check The Serial Number...

Buying a huawei watch can sometimes be a dream come true, especially if you have had b... - Synology DiskStation Manager

Der DiskStation Manager (DSM) ist das Betriebssystem für die Network Attached Storage-Systeme (NAS... - SAN vs. NAS: Unterschied ...

„Big Data“ lässt grüßen! Laut einer Studie des Festplatten-Giganten Seagate soll sich der weltweit... - Online Banking Software: 4...

Wer Bankgeschäfte über das Internet erledigen möchte, muss dafür nicht zwingend über die Internets... - Ninite – das wohl nützlic...

System-Tools gibt es wie Sand am Meer. Die meisten versprechen viel und halten wenig. Wirklich gut... - Digitalisierung anpacken:...

Die Corona-Pandemie hat ohne Zweifel einen starken Beitrag zur Digitalisierung kleinerer und mitte...

populäre Artikel

- How to Check The Serial Number...

Buying a huawei watch can sometimes be a dream come true, especially if you have had b... - Synology DiskStation Manager

Der DiskStation Manager (DSM) ist das Betriebssystem für die Network Attached Storage-Systeme (NAS... - Online Banking Software: 4...

Wer Bankgeschäfte über das Internet erledigen möchte, muss dafür nicht zwingend über die Internets... - Einrichten einer lokalen...

Dieser Artikel richtet sich an alle Hobby-Webentwickler, die ihre erstellten Web-Projekte auf dem... - Digitalisierung anpacken:...

Die Corona-Pandemie hat ohne Zweifel einen starken Beitrag zur Digitalisierung kleinerer und mitte...

Lieblingsartikel

- SAN vs. NAS: Unterschied ...

„Big Data“ lässt grüßen! Laut einer Studie des Festplatten-Giganten Seagate soll sich der weltweit... - Online Banking Software: 4...

Wer Bankgeschäfte über das Internet erledigen möchte, muss dafür nicht zwingend über die Internets... - Ninite – das wohl nützlic...

System-Tools gibt es wie Sand am Meer. Die meisten versprechen viel und halten wenig. Wirklich gut... - Einrichten einer lokalen...

Dieser Artikel richtet sich an alle Hobby-Webentwickler, die ihre erstellten Web-Projekte auf dem...